统计语言模型, 神经网络 模型和预训练模型

1 绪论

1. 基本概念 (p.1)

1.1 术语定义

▪️ 计算语言学(CL)、自然语言处理(NLP)、自然语言理解(NLU)常被视为同义概念

▪️ 刘颖(2002)专著中将三者直接等同

【需确认】是否所有文献都接受这种等同关系

1.2 HLT发展历史

▪️ 1946年ENIAC计算机诞生标志着技术起点

▪️ 关键人物:Warren Weaver(信息论先驱)、A.D.Booth(计算机科学家)

▪️ Norbert Wiener首次提出机器翻译设想

2. 发展历程 (p.3)

2.1 初创期(1950s-1960s)

2.1.1 学术里程碑

▪️ 1954年Georgetown大学实现首个俄英MT系统(IBM-701)

▪️ 1962年ACL成立,1965年ICCL成立

【表1】关键学术组织成立时间表 (p.3)

2.1.2 学派分野

▪️ 符号学派:Chomsky《句法结构》提出生成语法

▪️ 随机学派:Bledsoe应用贝叶斯方法于字符识别

2.2 理性主义时代(1970s-1980s)

▪️ Q系统开创逻辑方法

▪️ SHRDLU系统实现规则范式玩具世界

▪️ 隐马尔可夫模型应用于词性标注

2.3 经验主义时代(1990s-2000s)

▪️ 语料库方法引入机器翻译(1989)

▪️ 机器学习算法:SVM、CRF、神经网络等

2.4 深度学习时代(2006-至今)

▪️ 2006年DBN开启深度学习方法

▪️ 2014年Seq2Seq模型突破机器翻译

▪️ 2018年后BERT/GPT等大模型崛起

3. 研究内容 (p.7)

3.1 核心技术领域

▪️ 机器翻译(MT):跨语言自动转换

▪️ 自动文摘:单文本/多文本摘要生成

【示例】Columbia Newsblaster系统 (p.8)

▪️ 问答系统:IBM Watson在Jeopardy!获胜

3.2 应用方向

▪️ 信息过滤:网络内容安全管控

▪️ 语音识别:同音词处理是主要挑战

▪️ 知识图谱:实体关系语义网络

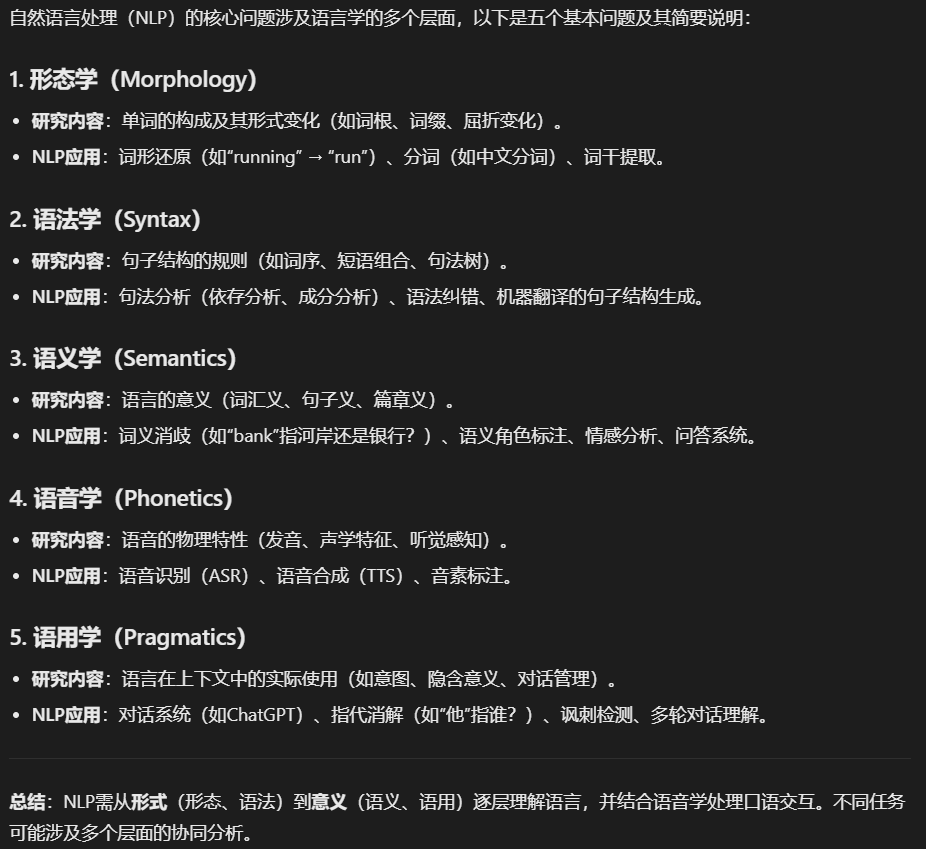

4. 基本问题 (p.12)

4.1 语言学层面

▪️ 语义学:词义与句法结构推导

▪️ 语用学:上下文对理解的影响

▪️ 语音学:音素分类与转写方法

4.2 典型歧义类型

▪️ 词义歧义:”意思”的6种不同含义

▪️ 结构歧义:”I saw a man with a telescope”

▪️ 语音歧义:汉语同音字问题(例《施氏食狮史》)

5. 技术方法 (p.15)

5.1 基于规则的方法

▪️ 优点:可解释性强,不依赖大数据

▪️ 缺点:规则构建成本高,覆盖率低

5.2 机器学习方法

▪️ 流程:特征工程→模型选择→优化

▪️ 瓶颈:错误传播与经验依赖

5.3 深度学习方法

▪️ 表示学习自动提取特征

▪️ 预训练-微调范式成为主流

5.4 大模型方法

▪️ ChatGPT展示通用任务理解能力

▪️ 三阶段范式:预训练→能力注入→任务适配

6. 本章总结 (p.18)

▪️ NLP是AI领域”皇冠上的明珠”

▪️ 面临核心挑战:歧义性、数据不充分性、知识表达复杂性

▪️ 多学科交叉:语言学+计算机科学+认知心理学

2 数学基础1

2.1 概率论基础 (p.3/32)

基本概念

▪️ 核心概率要素:概率函数、条件概率、贝叶斯公式、期望与方差

▪️ 分布类型:二项式分布与高斯分布

▪️ 应用关联:自然语言处理中的概率假设

【公式】概率公理体系:

$$\forall a\in A,P(a)\geq 0$$

$$\sum_{a\in A}P(a)=1$$

$$P(\cup_{i=1}^{\infty} a_i)=\sum_{i=1}^{\infty} P(a_i)$$

概率(Probability)

▪️ 定义:0-1实数表示随机事件可能性

▪️ 公理体系:非负性、规范性、可数可加性

【公式】条件概率定义:

$$P(A\mid B)=\frac{P(A\cap B)}{P(B)}$$

全概率公式

▪️ 样本空间划分要求:互斥且完备

▪️ 全概率计算:通过划分事件的条件概率加权和

【公式】全概率表达式:

$$P(A)=\sum_{i=1}^{n} P\left(B_{i}\right) P\left(A\mid B_{i}\right)$$

概率论中的链式法则

▪️ 联合概率分解:条件概率的连乘积形式

▪️ NLP应用:多变量依赖关系建模

【公式】N维链式法则:

$$ P(X_1,…,X_n)=P(X_1|X_2,…,X_n)\cdot P(X_2|X_3,…,X_n)\cdots P(X_n)$$

贝叶斯定理(Bayes’ Theorem)

▪️ 核心思想:先验概率→后验概率的更新机制

▪️ 分类应用:特征向量条件下的类别判断

【公式】多分类贝叶斯:

$$ P\left(w_i\mid\overline{x}\right)=\frac{P\left(\overline{x}\mid w_i\right) P\left(w_i\right)}{\sum_{j=1}^c P\left(\overline{x}\mid w_j\right) P\left(w_j\right)}$$

例2:句法结构检测 (p.7)

▪️ 问题原型:罕见事件(1/100000)的误报分析

▪️ 计算过程:结合先验概率与误报率

【公式】贝叶斯计算:

$$\begin{align} P(G\mid T)&=\frac{0.95\times 0.00001}{0.95\times 0.00001+0.005\times 0.99999}\ &\approx 0.002 \end{align}$$

期望与方差

▪️ 期望:随机变量的概率加权平均

▪️ 方差:偏离期望的二次矩度量

【公式】方差计算:

$$\operatorname{Var}(X)=E\left(X^{2}\right)-E^{2}(X)$$

二项式分布(binomial distribution)

▪️ 伯努利试验:独立重复n次二值实验

▪️ NLP假设:句子概率的分布近似

【公式】概率质量函数:

$$P(r)=C_{n}^{r} p^{r}(1-p)^{n-r}$$

高斯分布(Gaussian Distribution)

▪️ 特性:最大熵分布、自然现象拟合

▪️ 参数控制:μ决定位置,σ²控制离散度

【公式】正态分布:

$$\mathcal{N}(x,\mu,\sigma^2)=\sqrt{\frac{1}{2\pi\sigma^2}}\exp\left(-\frac{(x-\mu)^2}{2\sigma^2}\right)$$

激活函数(Activation function)

Logistic sigmoid

▪️ 特性:S型曲线、输出(0,1)

▪️ 导数特性:σ'(x)=σ(x)(1-σ(x))

【公式】:

$$\sigma(x)=\frac{1}{1+\exp(-x)}$$

Tanh

▪️ 双曲正切:输出(-1,1)

▪️ 梯度特性:1-tanh²(x)

ReLU

▪️ 计算优势:缓解梯度消失

▪️ 缺陷:负区间梯度归零

Softmax

▪️ 多类归一化:输出概率向量

【公式】:

$$\text{Softmax}\left(x_j\right)=\frac{e^{x_j}}{\sum_{k=1}^K e^{Z_k}}$$

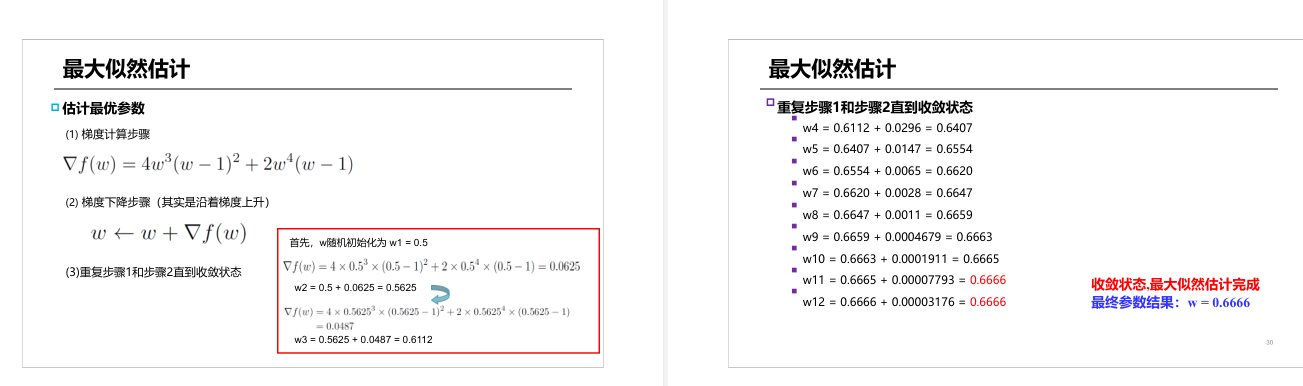

最大似然估计(MLE)

▪️ 参数学习:通过样本反推分布参数

▪️ 实例演示:硬币概率估计

【计算流程】:

- 定义似然函数 $P(X|w)=w^4(1-w)^2$

- 梯度上升迭代(w初始=0.5)

- 收敛至w≈0.6666

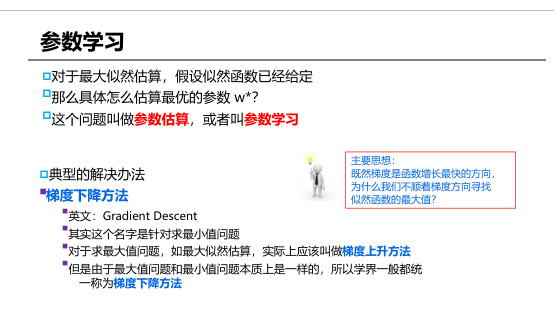

梯度下降方法(用于最大似然估计 这个实际上叫做梯度上升法 )

▪️ 优化原理:沿梯度方向参数更新

▪️ 应用场景:配合MLE进行参数学习

原始:$\nabla f(w)=4w^{3}(w-1)^{2}+2w^{4}(w-1)$

2 数学基础2

2.1 概率论基础

▪️ 基础概念未展开说明

[需确认] 该节内容是否完整

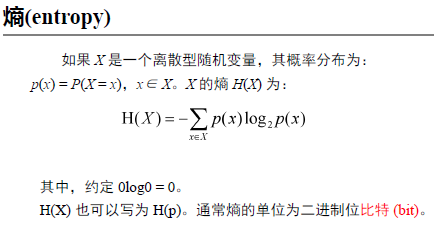

2.2 信息论基础 (重复标题,p.1)

熵(entropy)

▪️ 香农1948年奠定信息论基础

▪️ 离散随机变量熵定义:$H(X)=-\sum_{x\in X} p(x)\log_2 p(x)$

▪️ 熵反映随机变量的不确定性

【公式】熵计算公式 (p.1)

英语字母的熵-等概率情况

▪️ 27字符等概率时熵=4.75 bits/letter

【计算过程】完整推导 (p.2)

英语字母的熵-实际情况

▪️ 实际概率分布下熵=4.02 bits/letter

▪️ 实际分布比等概率不确定性更低

【表】字母概率分布表 (p.2)

联合熵(joint entropy)

▪️ 定义:$H(X,Y)=-\sum\sum p(x,y)\log_2 p(x,y)$

▪️ 描述一对随机变量所需信息量

【公式】联合熵公式 (p.3)

条件熵(conditional entropy)

▪️ 定义:$H(Y|X)=-\sum\sum p(x,y)\log_2 p(y|x)$

▪️ 表示已知X时Y的不确定性

【公式】条件熵推导 (p.3)

熵的连锁规则

▪️ $H(X,Y)=H(X)+H(Y|X)$

▪️ 联合熵分解规则

【公式推导】完整展开过程 (p.3-4)

举例:波利尼西亚语

▪️ 字符熵计算示例:2.5 bits

▪️ CV音节结构分析

【编码表】字符二进制编码 (p.4)

【联合概率表】音节分布 (p.5)

熵率(entropy rate)

▪️ 长文本单位字符熵:$H_{rate}=\frac{1}{n}H(X_{1n})$

▪️ 示例中文句子n=66

【示例】科普文本分析 (p.6)

互信息(mutual information)

▪️ 定义:$I(X;Y)=\sum\sum p(x,y)\log\frac{p(x,y)}{p(x)p(y)}$

▪️ 反映变量间依赖程度

【公式】互信息三种表达式 (p.7)

互信息与熵的关系

▪️ $I(X;Y)=H(X)-H(X|Y)$

▪️ 自信息是互信息的特例

【示意图】熵关系图 (p.7)

汉语分词应用

▪️ 互信息判断汉字结合强度

▪️ 双字耦合度替代方案

【对比分析】互信息vs耦合度 (p.8-9)

相对熵(KL散度)

▪️ 定义:$D(p|q)=\sum p(x)\log\frac{p(x)}{q(x)}$

▪️ 衡量概率分布差异

【示意图】KL散度图示 (p.10)

交叉熵(cross entropy)

▪️ 定义:$H(X,q)=-\sum p(x)\log q(x)$

▪️ 用于定义损失函数

【示例】三分类预测案例 (p.11)

【表格】3次预测结果对比 (p.11-12)

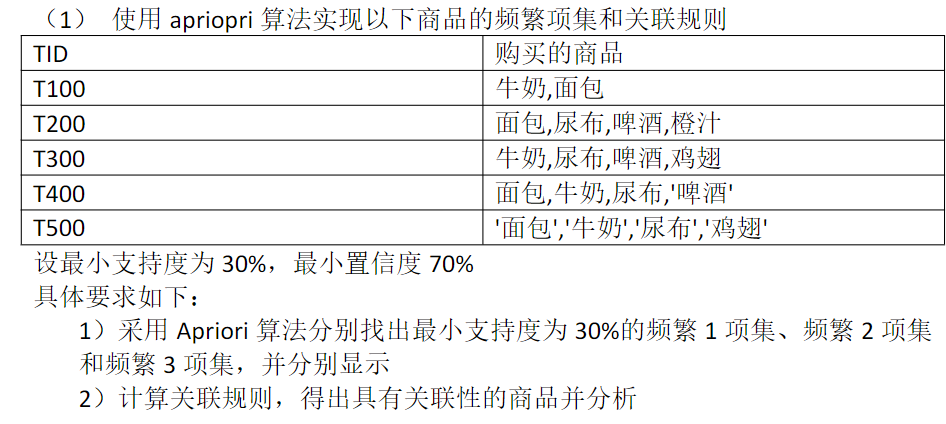

4 语料库与语言知识库 (p.1)

4.1 基本概念 (p.2-3)

▪️ 语料库定义:存放语言材料的仓库(语言数据库)

▪️ 语料库语言学:基于语料库进行语言学研究的主流方法

▪️ 研究内容:建设编纂、加工管理、使用应用三大方向

【引文】J.Thomas评价语料库语言学影响 (p.3)

4.2 语料库技术的发展 (p.3-5)

4.2.1 三个阶段

1. 早期(1950s前)

▪️ 广泛应用于语言习得、方言学等领域

2. 沉寂期(1957-1980s)

▪️ 受Chomsky转换生成语法学派批判

▪️ 主要争议:研究方法缺陷与语料不充分性

3. 复苏期(1980s后)

▪️ 特征:第二代语料库建成(LOB/TLF/ICE等)

▪️ 研究项目数量显著增长(1981-1991年480项)

▪️ 复苏原因:计算机发展+生成语言学批判存在片面性

4.3 国内研究状况 (p.5-7)

▪️ 早期建设:武大/北航/北师大等高校1979-1983年汉语语料库

▪️ 国家级项目:1991年7000万汉字语料库计划

▪️ 代表机构:

- 北京大学CLKB:国际最大规模汉语知识库

- 清华大学:歧义切分语料库(1亿汉字)

【机构列表】山西大学/哈工大/中科院等贡献单位 (p.6)

【民族语料库】新疆/内蒙古/西藏等地少数民族语言库 (p.7)

4.4 语料库类型 (p.8-10)

4.4.1 分类维度

1. 语言种类

▪️ 单语/双语/多语

▪️ 对齐方式:篇章/句子/结构

2. 标注程度

▪️ 生语料 vs 熟语料(词性/句法/语义标注)

3. 平衡语料库

▪️ 七项采集原则:真实性、科学性、分布性等

【引用】张普2003年分布性标准 (p.9)

4. 平行语料库

▪️ 同语言平行(如国际英语语料库)

▪️ 跨语言平行(机器翻译对齐语料)

【示例】汉英句子对齐代码段 (p.10):

# 汉英句子对齐示例

C: 早晨好!

E: Good morning.4.4.2 时空维度

▪️ 共时语料库:研究特定时段语言特征

▪️ 历时语料库:追踪语言演变过程

4.5 典型语料库 (p.11-14)

4.5.1 国际语料库

▪️ 布朗语料库:首个系统性标准库(100万词)

▪️ LLC口语库:标注语调/节律等特征

▪️ UPenn树库:300万词语法结构标注

【汉语树库】CTB 10万词次/33类词性标注 (p.12)

# 汉语分词标注示例

他/PN 还/AD 提出/VV...4.5.2 国内语料库

▪️ 北大CLKB:含8万词语法词典/1.5亿字加工语料

▪️ 中文语言资源联盟:80余种语言资源

【表格】CASIA-CASSIL电话对话语料统计 (p.14):

| 场景 | 对话数 | 字数 | 词数 |

|---|---|---|---|

| 旅馆 | 206 | 78,950 | 57,800 |

特殊内容标注

【代码段】Python语料处理示例 (p.12):

from pyhanlp import *

NLPTokenizer = JClass("com.hankcs.hanlp.tokenizer.NLPTokenizer")

print(NLPTokenizer.segment("他还提出..."))【术语】”熟语料”需与”生语料”对比理解 (p.8)

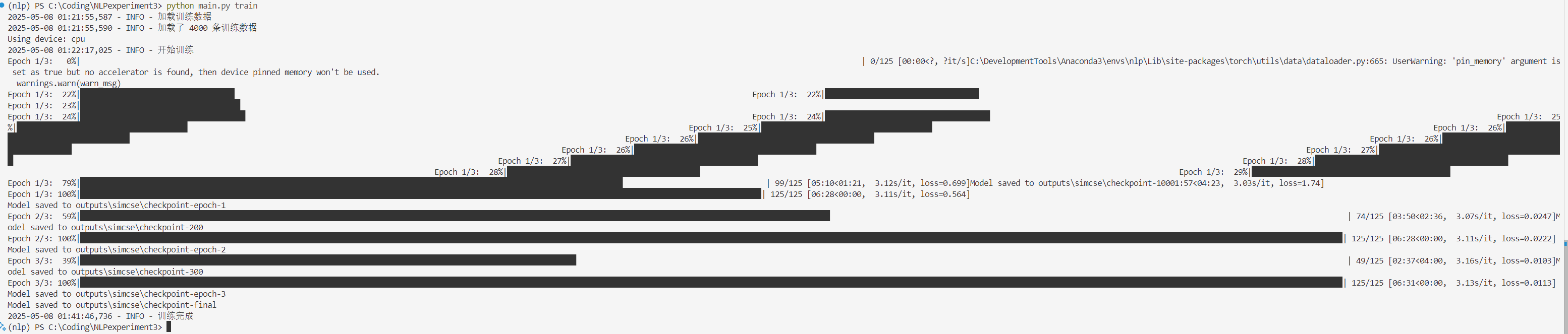

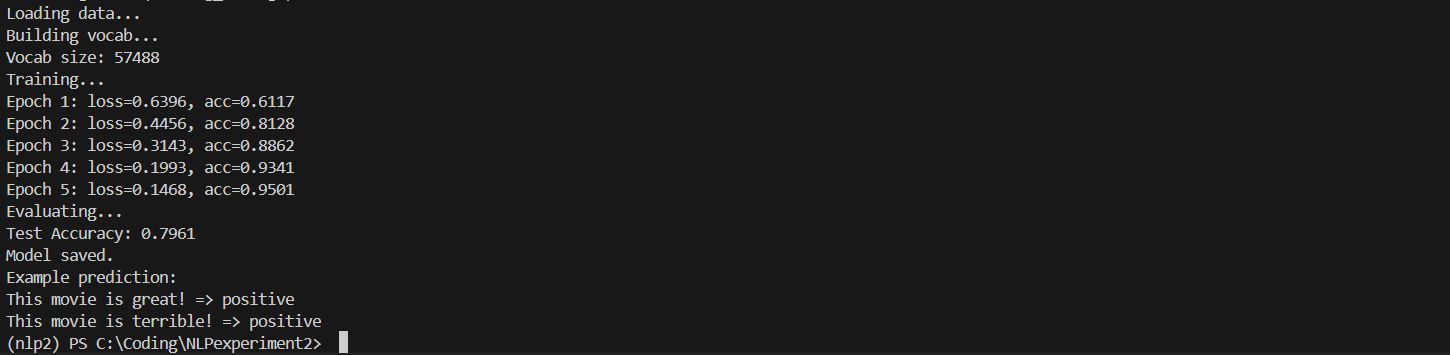

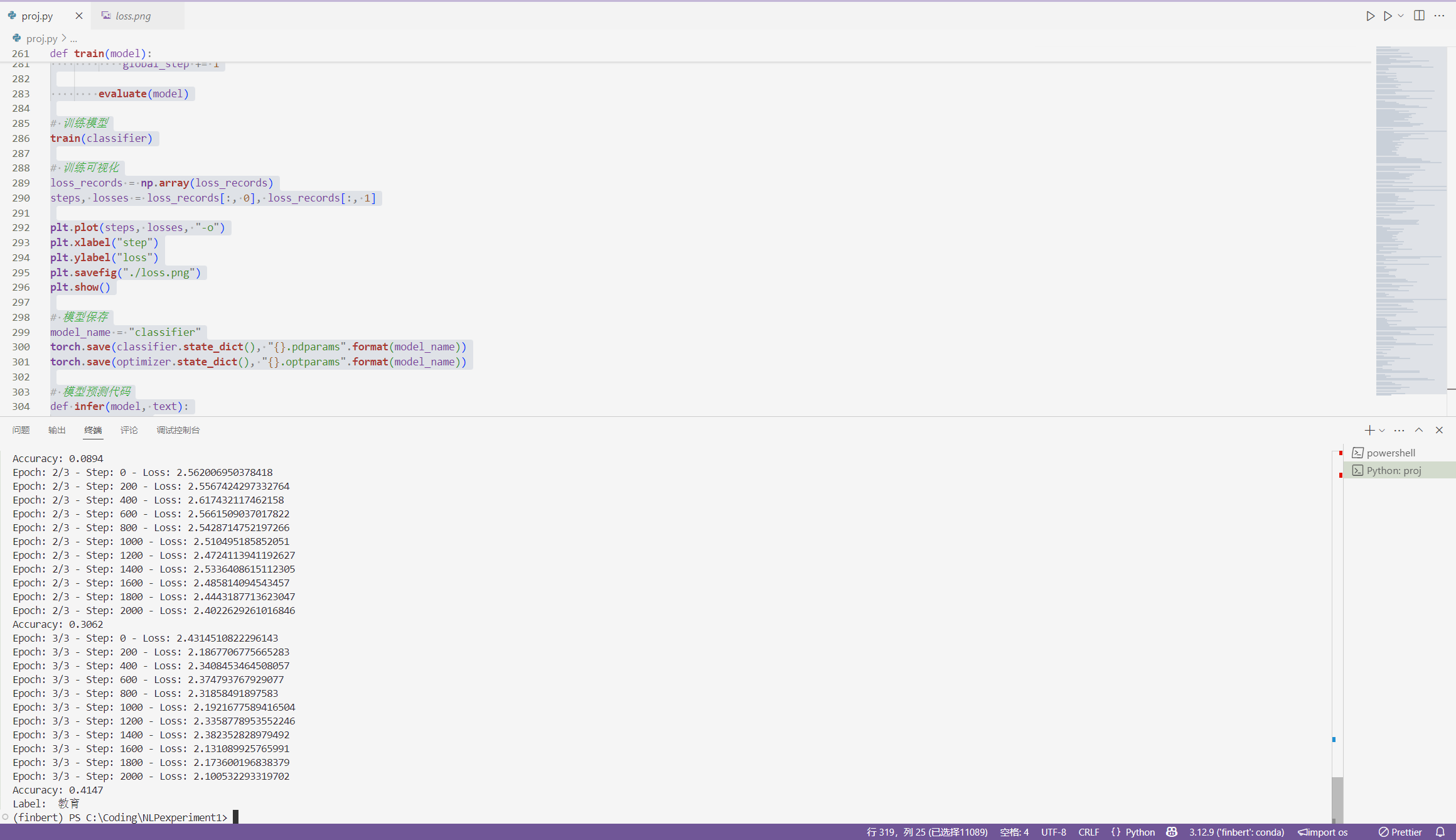

5 语言模型

5.1 基本概念 (p.X)

5.1.1 语言模型

▪️ 本质是判断语句合理性,通过概率分布评估句子可能性

▪️ 使用链式规则分解句子概率:

【公式】P(a) = \prod_{k=1}^m P(w_k|w_1\ldots w_{k-1})

【例】”Do you still remember”的概率分解示例 (p.6)

5.1.2 统计语言模型

▪️ 发展历程:专家语法规则→统计模型→神经网络→预训练模型

▪️ 应用领域:语音识别、机器翻译、信息检索等

【公式】统计基元可为字/词/短语,历史序列决定当前词概率

5.1.3 N-gram模型

模型特性

▪️ 马尔科夫假设:词概率仅依赖前n-1个词

▪️ 参数规模随n值指数增长(20000词时:unigram需2万参数,bigram需4亿参数)

模型类型

Unigram (n=1)

▪️ 独立词频统计

【公式】P(S) \approx \prod P(w_i)

Bigram (n=2)

▪️ 基于前词的条件概率

【公式】P(S) \approx P(w_1)\prod_{i=2}^m P(w_i|w_{i-1})

【例】John read…的概率计算过程 (p.8)

Trigram (n=3)

▪️ 双重历史依赖关系

【公式】P(S) \approx P(w_1)P(w_2|w_1)\prod_{i=3}^m P(w_i|w_{i-2}w_{i-1})

边界处理

▪️ 添加/标记保证概率归一化

【例】”John read a book”的bigram标注过程 (p.9)

5.1.4 应用场景

音字转换

▪️ 通过最大后验概率选择最优汉字串

【公式】\widehat{C} = \arg\max p(\text{CString}|\text{Pinyin})

汉语分词

▪️ 比较不同分词路径的bigram概率

【例】”他是研究生物的”两种分词方案对比 (p.10)

参数估计 (p.X)

最大似然估计(MLE)

▪️ 基于训练语料的频率统计方法

【公式】P_{MLE}(w_n|w_1\ldots w_{n-1}) = \frac{c(w_1\ldots w_n)}{c(w_1\ldots w_{n-1})}

▪️ 需要处理数据稀疏问题

训练语料实例

▪️ 包含3个带边界标记的简单句子

【例】计算”The dog is walking”的bigram概率过程 (p.11)

【需确认】示例中是否包含足够训练数据支持参数估计

数据平滑和评价

答案

平滑前,句子“Cher read a book”的概率:

由于训练数据中未出现“Cher”在句首以及“read”跟在“Cher”之后的情况,导致部分条件概率为0,因此整体概率为:

p(\text{Cher read a book}) = 0Add-one平滑后的概率计算步骤:

- 词汇量V确定: 训练语料中不同的词汇(不包括和)共有11个,即V=11。

- 各条件概率计算:

p(\text{Cher} \mid \text{<BOS>}) = \frac{0 + 1}{3 + 11} = \frac{1}{14}p(\text{read} \mid \text{Cher}) = \frac{0 + 1}{1 + 11} = \frac{1}{12}p(\text{a} \mid \text{read}) = \frac{2 + 1}{3 + 11} = \frac{3}{14}p(\text{book} \mid \text{a}) = \frac{1 + 1}{2 + 11} = \frac{2}{13}p(\text{<EOS>} \mid \text{book}) = \frac{1 + 1}{2 + 11} = \frac{2}{13}

- 整体概率乘积:

\begin{aligned}

p(\text{Cher read a book}) &= \frac{1}{14} \times \frac{1}{12} \times \frac{3}{14} \times \frac{2}{13} \times \frac{2}{13} \\

&= \frac{1 \times 1 \times 3 \times 2 \times 2}{14 \times 12 \times 14 \times 13 \times 13} \\

&= \frac{12}{397,488} \approx 0.00003

\end{aligned}最终答案:

- 平滑前概率:0

- Add-one平滑后概率:约0.00003

公式说明:

- Add-one平滑公式:

P_{\text{Add-one}}(w_i \mid w_{i-1}) = \frac{C(w_{i-1}, w_i) + 1}{C(w_{i-1}) + V} - 其中,

C为计数,V为词汇量,通过调整概率分布避免零概率问题,提升模型泛化能力。